Искусственный интеллект из контакт-центров будет распознавать голоса липчан по эмоциям

Искусственный интеллект из контакт-центров будет распознавать голоса липчан

© Нейросеть Регина/Николай Вальковский

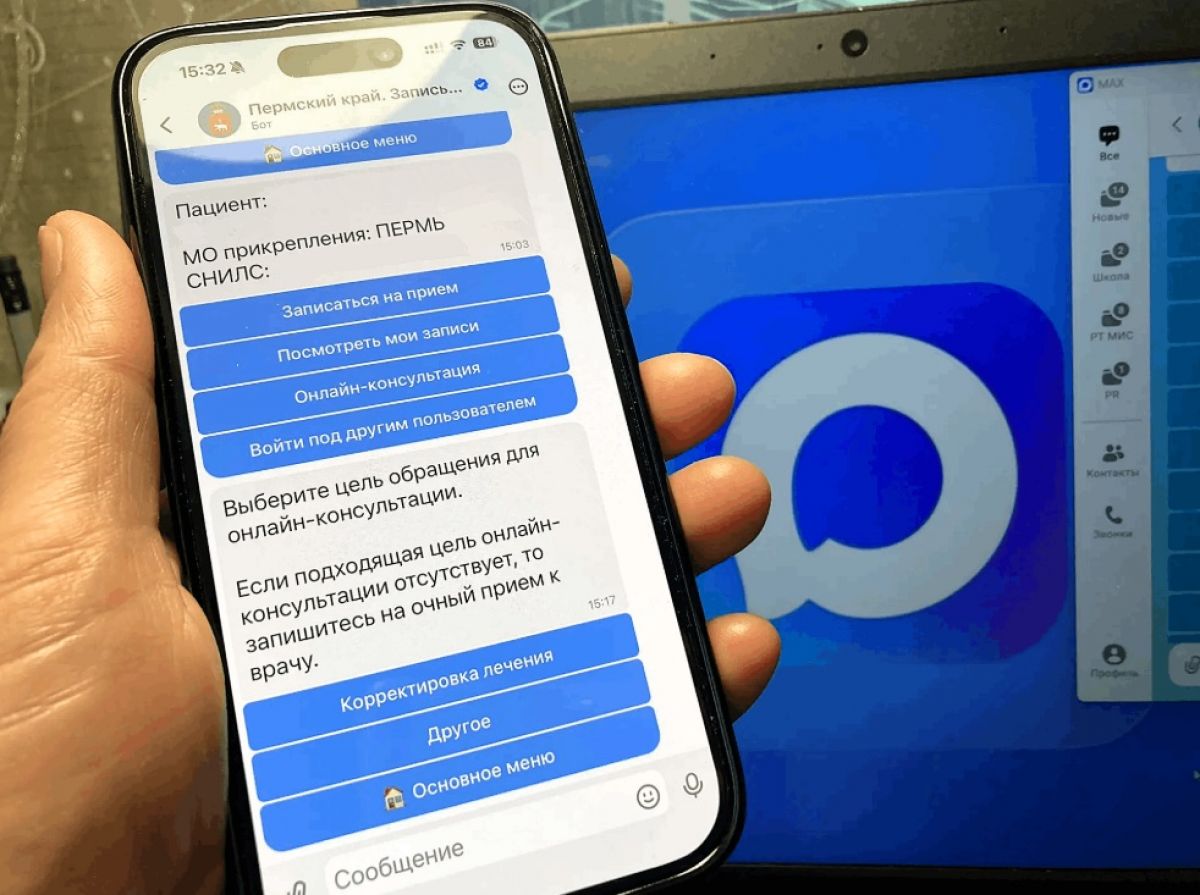

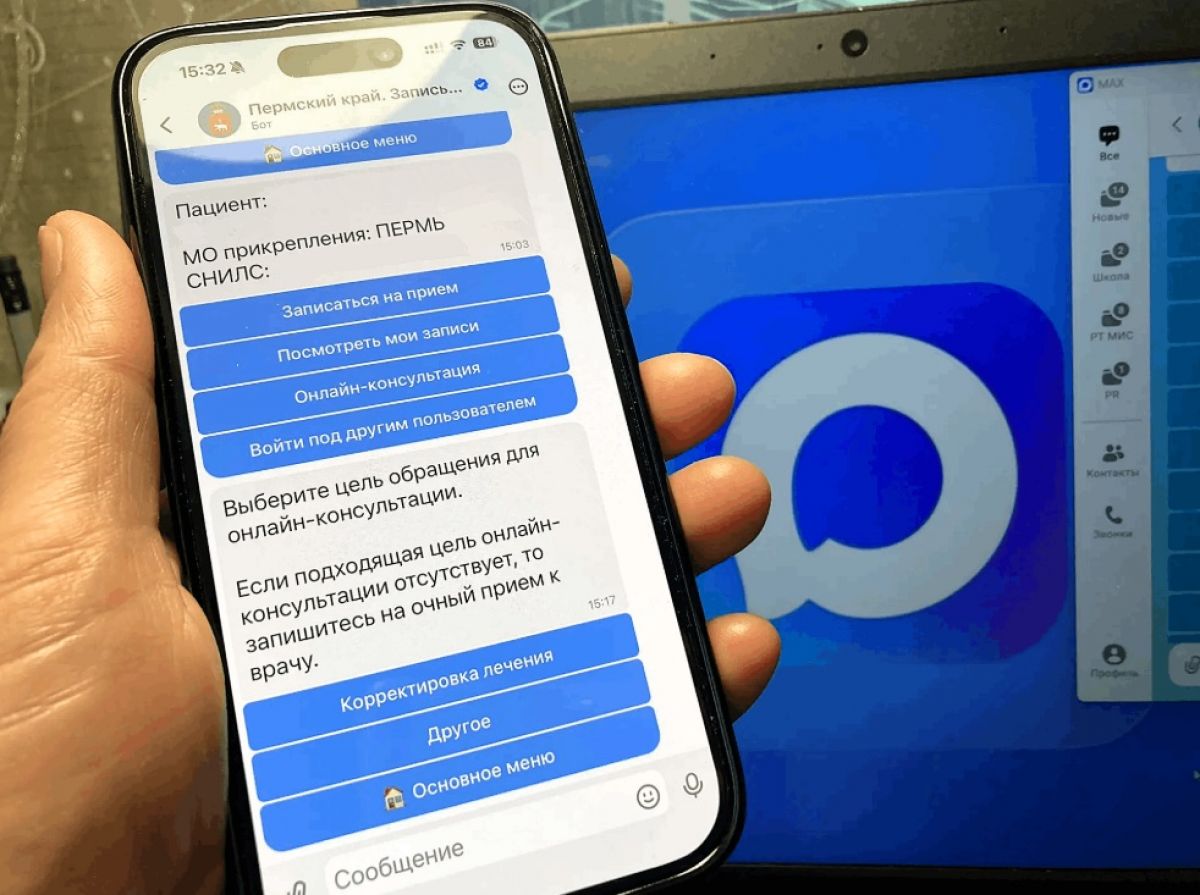

Исследователи лаборатории искусственного интеллекта Сбербанка, Института AIRI и МФТИ представили AI-модель Cross-Attention Feature Fusion for Speech Emotion Recognition (CA-SER) для распознавания эмоций человеческой речи. Модель достигла высокой взвешенной точности 74,6% на одном из наиболее сложных для проверки функционала модели датасетов IEMOCAP (Interactive Emotional Dyadic Motion Capture), качество её работы превосходит большинство существующих методов.

Сначала система детектирует важные характеристики речи, а затем добавляет к ним данные о звуках голоса (например, их громкость и тональность). Эти два типа информации объединяются с помощью специального механизма, эффективно соединяя общие характеристики речи с её детальными особенностями, что помогает точнее определять эмоции говорящего человека.

Этот инструмент решает проблему несоответствия чистых аудиоданных, на которых обучены SSL-модели, и эмоциональных датасетов с различной интонацией и интенсивностью. Он будет полезен в системах автоматического взаимодействия с человеком –– голосовых чат-ботах, кол-центрах, а также в приложениях цифрового мониторинга психологического здоровья и других областях, где нужно анализировать эмоции в режиме реального времени.

Исходный код модели доступен в open source, поэтому исследователи и другие учёные могут использовать инструмент в своих исследованиях, чтобы провести дополнительные эксперименты для проверки обобщаемости модели на другие языки и датасеты, повысить её универсальность и применимость в реальных условиях. Так, модель можно обучать на русскоязычных эмоциональных корпусах и затем применять в голосовых помощниках и контакт-центрах.